国内首个自研MoE多模态大模型,揭秘腾讯混元多模态理解

发布时间:2024-09-02

腾讯混元多模态大模型近日在中文多模态大模型评测基准SuperCLUE-V中斩获国内排名第一,超越了多个主流闭源模型。这一成绩标志着国内首个自研MoE多模态大模型的诞生,展现了中国AI技术在多模态理解领域的突破性进展。

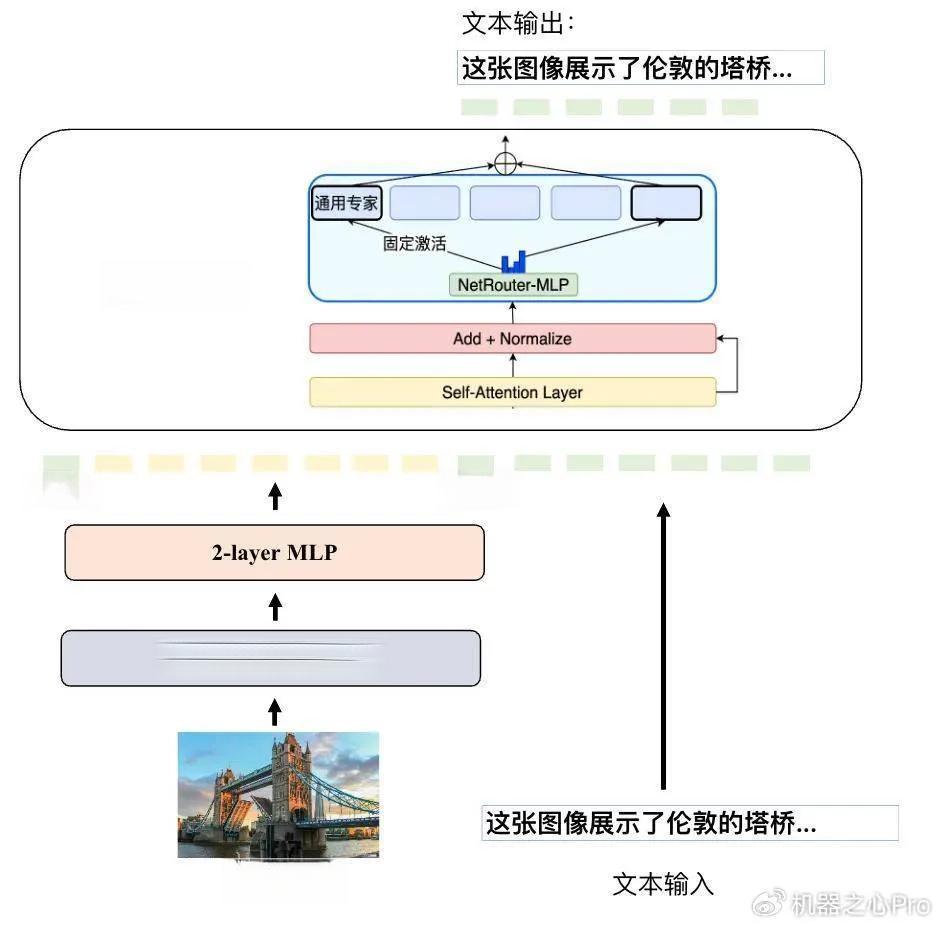

腾讯混元多模态大模型采用了创新的MoE(Mix of Experts,专家混合)架构,这是国内大模型中率先完成的架构升级。相比传统的单个稠密模型,MoE架构由多个专家组成稀疏模型,能够更好地兼容更多模态和任务,确保不同模态和任务之间是互相促进而非竞争的关系。这种架构使得模型在处理海量通用任务时表现出色,总体性能相比上一代提升50%,部分中文能力已追平GPT-4o。

在SuperCLUE-V评测中,混元多模态理解系统hunyuan-vision取得了71.95分的高分,仅次于GPT-4o。值得注意的是,SuperCLUE-V评测更侧重于中文能力评测,关注用户的真实问题,而此前业界的多模态评测多集中于英文能力。这种评测方式更能反映模型在实际应用中的表现,也体现了腾讯混元多模态大模型在中文理解方面的优势。

腾讯混元多模态大模型在实际应用中也展现出了强大的能力。在腾讯元宝APP中,用户可以免费体验到该模型的多模态理解功能。例如,在处理梗图表情包理解时,模型能够准确理解图片的含义;在照片内容识别方面,模型不仅能正确识别出图片中的物体,还能根据图片内容进行推理;在视觉错觉挑战中,模型的表现也相当出色。此外,模型在处理财报表现摘要读取、学术图表读取、行测找规律题等实用场景时,都能给出准确的答案和详细的解释。

腾讯混元多模态大模型的成功,不仅展示了中国AI技术在多模态理解领域的突破,也为未来AI的发展提供了新的思路。MoE架构的应用,为解决海量通用任务提供了新的可能性;而对中文理解能力的重视,则体现了AI技术在本土化应用中的重要性。随着多模态大模型技术的不断进步,我们有理由相信,AI将在更多领域展现出强大的能力,为人类社会带来更多的便利和创新。