十年磨一剑:谷歌TPU芯片为何能“吃下”苹果?

发布时间:2024-09-18

谷歌TPU芯片正在AI芯片领域掀起一场静默的革命。近日,苹果公司在其研究论文中公开表示,使用谷歌的TPU芯片而非英伟达的GPU来训练其人工智能系统,这一决定在科技界引发了巨大反响。苹果的这一选择,不仅标志着TPU在性能和效率上取得了重大突破,更预示着AI芯片市场的格局可能迎来重大变革。

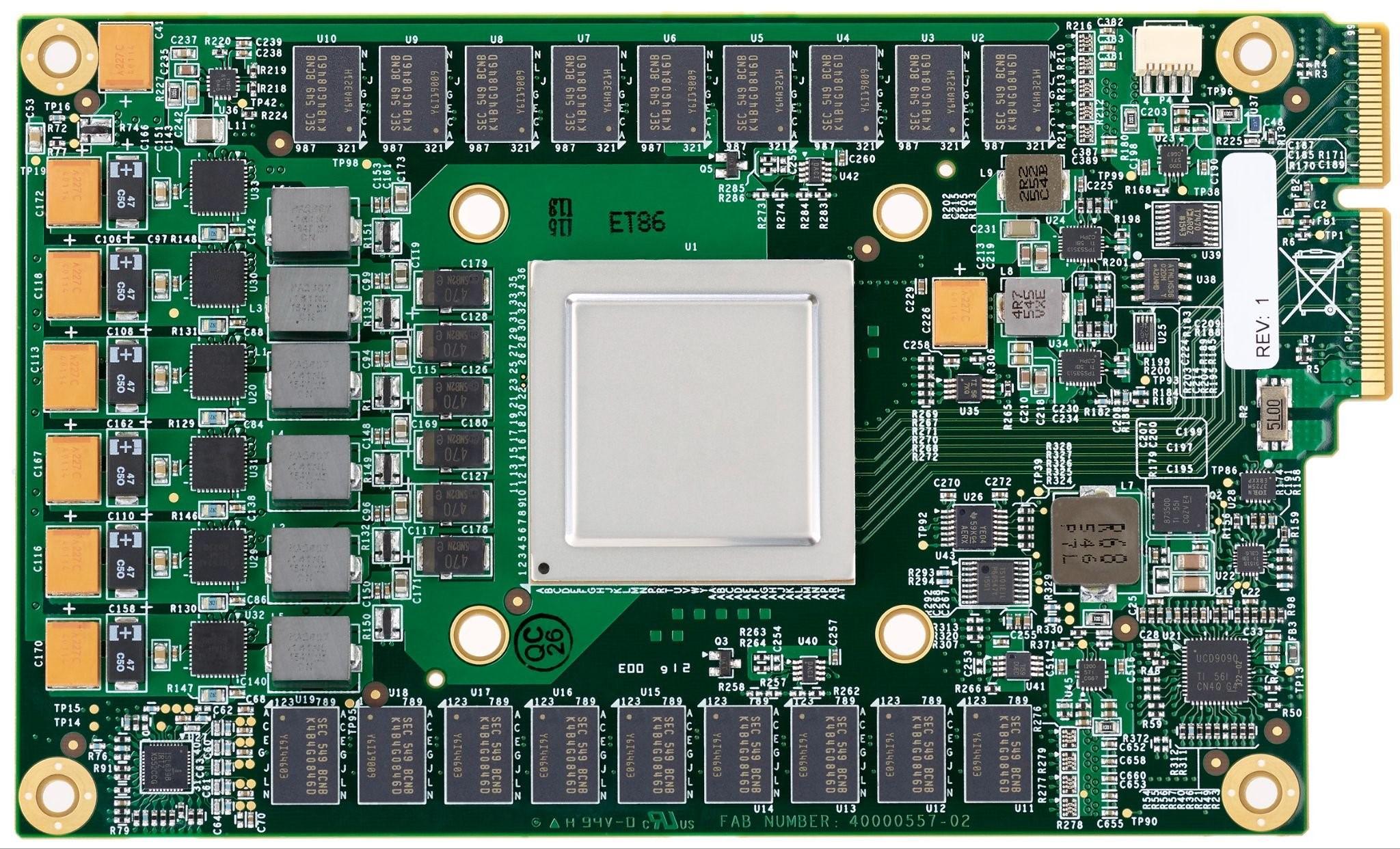

TPU(Tensor Processing Unit)是谷歌专为加速机器学习和深度学习任务而设计的专用芯片。与传统的GPU相比,TPU在设计之初就将满足机器学习/深度学习所需的高速数据流与计算流纳入核心设计理念中。这种针对性的设计使得TPU在处理大规模AI模型训练时展现出显著优势。

首先,TPU采用了多维度的计算单元,通过将卷积运算循环展开的方式实现最大限度的数据复用,从而显著提升计算效率。其次,TPU在数据传输和控制单元设计上更为激进,有效解决了冯诺依曼架构带来的存储墙问题。最后,TPU的架构简单,单线程控制,定制指令集,使其在深度学习运算方面效率极高,易于扩展,更适合超大规模的AI训练计算。

谷歌的TPUv4与英伟达A100相比,在功耗和效率上都展现出明显优势。据报道,TPUv4的功耗比A100低1.3-1.9倍,在Bert、ResNet等多类工作模型中,效率高于A100 1.2-1.9倍。更令人瞩目的是,谷歌最新的TPUv5和TPU Trillium产品相比TPUv4,能够进一步提升2倍甚至接近10倍的计算性能。

苹果选择谷歌TPU的原因可能在于以下几个方面:首先,TPU在处理大规模分布式训练任务时表现出色,提供高效、低延迟的计算能力;其次,使用Google Cloud平台,苹果可以降低硬件成本,灵活调整计算资源,优化AI开发的总体成本。此外,谷歌的AI开发生态系统还提供了丰富的工具和支持,使得苹果能够更高效地开发和部署其AI模型。

值得注意的是,谷歌并没有选择直接销售TPU芯片,而是通过谷歌云平台(Google Cloud Platform,简称GCP)向外部客户提供基于TPU的算力服务。这种策略不仅简化了销售流程,减少了供应链管理的复杂性,还使得谷歌能够更好地控制TPU的使用环境,确保其性能优势得到充分发挥。

然而,我们也不能忽视GPU在通用性和生态系统成熟度方面的优势。GPU经过多年的发展,拥有庞大且成熟的软件和开发工具生态,能够适应多种不同类型的计算任务。相比之下,TPU作为专为机器学习工作负载定制设计的芯片,在非机器学习相关任务上的处理能力可能不如GPU。

尽管如此,TPU在AI大模型训练领域的优势已经得到了业界的广泛认可。随着AI技术的快速发展,对专门优化的AI芯片的需求将会持续增长。谷歌TPU的成功,不仅为AI芯片市场带来了新的活力,也为其他科技巨头提供了新的思路。未来,我们可能会看到更多针对特定AI任务优化的芯片出现,推动整个行业的技术创新。

苹果选择谷歌TPU的决定,无疑是对TPU性能和潜力的最好证明。这一选择不仅可能改变苹果自身的AI发展战略,也可能影响整个科技行业的芯片选择。随着更多公司开始探索TPU等新型AI芯片,我们有理由期待,未来的AI芯片市场将会更加多元化,技术创新的步伐也将进一步加快。