大白话浅谈Transformer架构

发布时间:2024-08-29

2017年,Google的研究团队发表了一篇题为《Attention Is All You Need》的论文,提出了一种全新的神经网络架构——Transformer。这个架构彻底改变了自然语言处理(NLP)领域,为深度学习处理序列数据提供了一个革命性的解决方案。

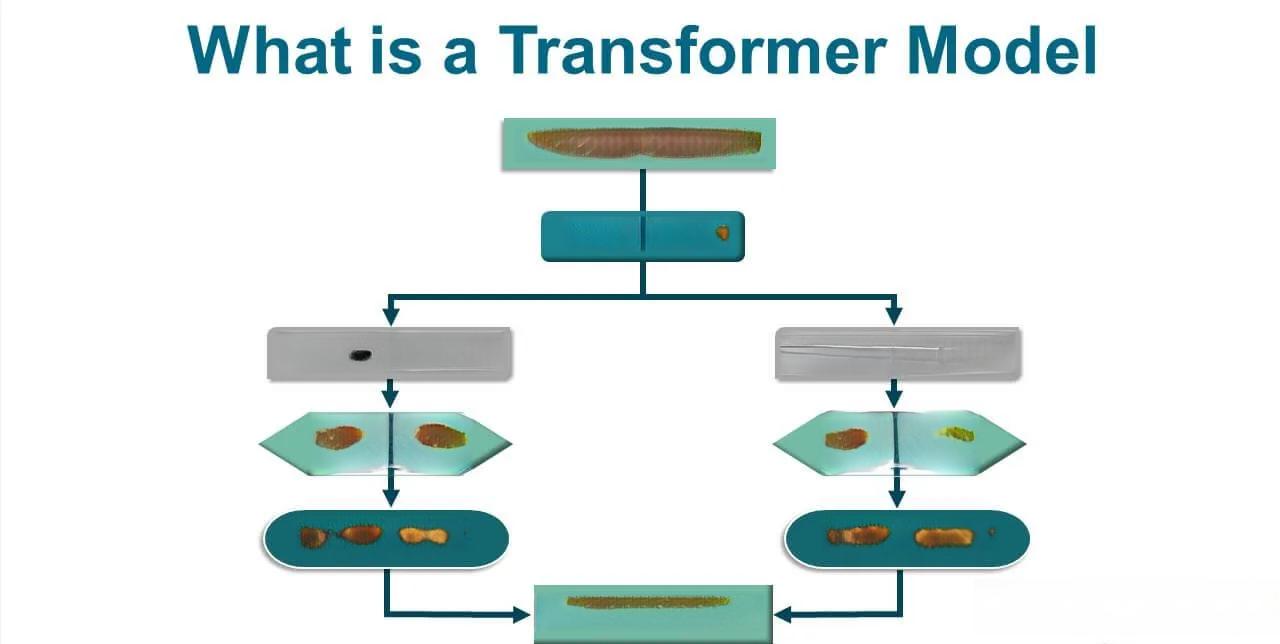

Transformer的核心创新在于其摒弃了传统的循环神经网络(RNN)和卷积神经网络(CNN)结构,完全依赖于自注意力机制(Self-Attention)来处理序列数据。这种设计使得Transformer能够并行处理输入的序列数据,大大提高了训练速度。相比之下,RNN需要逐个处理序列中的元素,难以实现高效并行计算。

自注意力机制是Transformer架构的灵魂。它允许模型在处理序列中的每个元素时,都能考虑到整个序列的信息。具体来说,自注意力机制为序列中的每个元素生成三个向量:查询(Query)、键(Key)和值(Value)。通过计算查询向量与所有键向量的点积,模型可以评估每个元素与其他元素的相关性,并据此对值向量进行加权求和。这个过程就像是为每个元素打开了一束聚光灯,不仅照亮了该元素,还揭示了它与其他元素的关系。

为了进一步增强模型的表达能力,Transformer采用了多头注意力机制(Multi-Head Attention)。这个机制将自注意力过程分解为多个并行的“头”,每个头都可以独立地计算注意力权重。这种设计使得模型能够从多个角度捕捉序列中元素之间的关系,从而获得更丰富、更全面的语义表示。

Transformer的另一个重要特点是位置编码(Positional Encoding)。由于自注意力机制本身无法捕捉序列中元素的顺序信息,Transformer通过在输入嵌入中加入特定的位置向量来解决这个问题。这些位置向量是根据元素在序列中的位置计算得出的,使得模型能够区分不同位置的元素。

Transformer架构的优越性在多个NLP任务中得到了验证。在机器翻译任务中,Transformer模型在英德翻译任务上创造了新的记录,相比之前的最佳模型提高了2个BLEU值。更重要的是,Transformer不仅在大规模数据集上表现出色,在小规模数据集上也能取得良好的效果。

Transformer的成功不仅限于学术研究。它迅速成为工业界处理序列数据的首选架构。例如,Google的BERT模型就是基于Transformer构建的,它在多个NLP任务上取得了突破性的成果。如今,几乎所有的主流大语言模型都是基于Transformer架构构建的。

Transformer的出现标志着NLP领域的一个重要转折点。它不仅解决了传统RNN和CNN在处理序列数据时的局限性,还为深度学习模型处理序列数据提供了一个全新的、更高效的框架。随着研究的深入和技术的发展,我们有理由相信Transformer将继续推动NLP领域的发展,为解决更复杂的语言理解问题提供强大的工具。