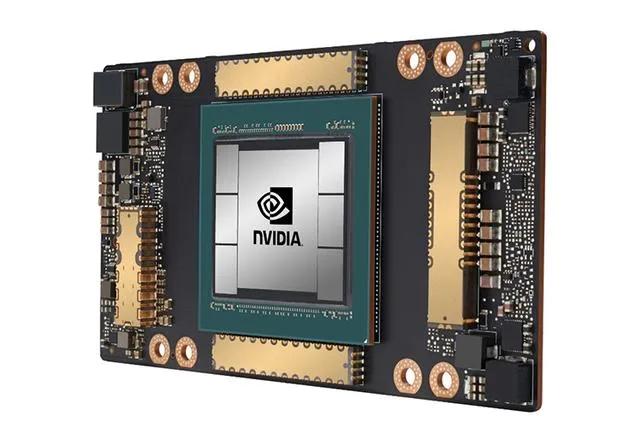

NVIDIA新一代A100 GPU解析:AI训练速度提升20倍的秘密是什么?

发布时间:2024-09-19

NVIDIA新一代A100 GPU将AI训练速度提升了20倍,这一惊人成就引发了业界广泛关注。那么,A100 GPU是如何实现如此巨大的性能飞跃的呢?

A100 GPU的性能突破主要归功于NVIDIA Ampere架构的创新。其中,最关键的技术是TensorFloat-32(TF32)和对稀疏性的支持。TF32是一种新的数值格式,它结合了FP32的范围和FP16的精度,能够在不牺牲精度的情况下大幅提高AI训练速度。与V100相比,A100在TF32模式下的性能提升了10倍,结合稀疏性支持后更是达到了20倍的提升。

稀疏性支持是另一个重要突破。A100 GPU能够利用深度学习网络中的细粒度结构稀疏性,将张量核心操作的吞吐量提高一倍。这意味着在处理具有大量零元素的稀疏矩阵时,A100能够更高效地利用计算资源。

除了这些核心技术创新,A100 GPU还具备其他显著优势。它拥有6912个CUDA核心和40GB HBM2内存,内存带宽高达1.6TB/s。这些硬件配置为AI训练和推理提供了强大的算力支持。此外,A100还支持多实例GPU(MIG)技术,可以将一个GPU划分为多达7个独立实例,大大提高了硬件利用率。

在实际应用中,A100 GPU展现出了卓越的性能。在BERT等先进的对话式AI模型上,A100的推理吞吐量比CPU高249倍。对于具有庞大数据表的超大型模型,如深度学习推荐模型(DLRM),A100 80GB版本的吞吐量比A100 40GB版本高出3倍。这些数据充分证明了A100 GPU在处理复杂AI任务时的强大能力。

A100 GPU的推出对数据中心和AI行业产生了深远影响。它不仅大幅提升了AI训练和推理的速度,还降低了能耗和空间占用。NVIDIA表示,一个由5台DGX A100系统组成的机架可以替代一个包含AI训练和推理基础设施的完整数据中心,功耗仅为1/20,占用空间仅为1/25,成本仅为1/10。这意味着企业可以以更低的成本获得更强大的AI计算能力,推动AI技术在各行各业的普及。

展望未来,A100 GPU的出现标志着GPU技术的一个重要里程碑。它不仅在性能上实现了质的飞跃,还为AI计算提供了更灵活、更高效的解决方案。随着AI应用的不断扩展和深化,我们有理由相信,像A100这样的高性能GPU将在推动AI技术进步和产业变革中发挥越来越重要的作用。