BN,LN,IN,GN都是什么?不同归一化方法的比较

发布时间:2024-09-15

深度神经网络的训练过程中,梯度不稳定问题一直是困扰研究者的一大难题。梯度消失和梯度爆炸不仅影响模型的收敛速度,还可能导致训练失败。为了解决这一问题,研究者们提出了多种归一化技术,其中Batch Normalization(BN)、Layer Normalization(LN)、Instance Normalization(IN)和Group Normalization(GN)是最为常见的四种方法。

BN技术如何解决梯度不稳定问题

Batch Normalization(BN)是最早被广泛采用的归一化技术。 它通过在每一层的激活函数之前对输入数据进行归一化处理,使得每一层的输入都具有零均值和单位方差。这种方法有效地解决了梯度消失和梯度爆炸问题,加速了网络的收敛速度,并提高了训练的稳定性。

BN的核心思想是通过规范化操作消除权重对梯度的影响。在反向传播求导公式中,含有权重w的项会影响梯度的大小。BN通过对每一层的输出进行均值和方差的标准化,消除了w带来的放大缩小影响,从而解决了梯度不稳定的问题。

LN和IN在特定场景下的优势

然而,BN并非万能的。在某些情况下,如循环神经网络(RNN)和生成对抗网络(GAN)中,BN的效果并不理想。为了解决这些问题,研究者们提出了Layer Normalization(LN)和Instance Normalization(IN)。

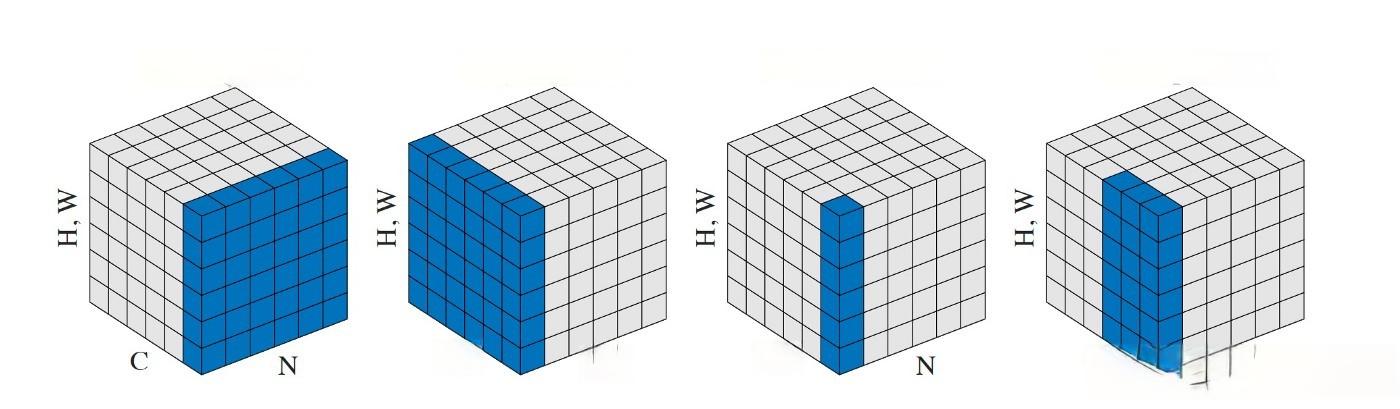

LN与BN类似,但它是在每个样本的特征维度上进行归一化,而不是在批量维度上。 这种方法更适合处理序列数据,如RNN中的输入序列。 IN则是在每个样本的每个特征图上进行归一化,主要用于图像生成任务 ,如GAN中的生成器网络。

GN技术平衡性能与计算效率

Group Normalization(GN)是另一种归一化技术,它将特征图分成若干组,并在组内进行归一化。 这种方法在保持BN优势的同时,减少了计算量,特别适合处理小批量数据。GN通过调整组的数量,可以在性能和计算效率之间找到平衡点。

不同归一化方法的适用场景

这四种归一化方法各有优势,适用于不同的场景:

- BN适用于大多数卷积神经网络(CNN)和全连接网络(FCN),特别是在处理大规模数据集时效果显著。

- LN更适合处理序列数据,如RNN和LSTM网络。

- IN主要用于图像生成任务,如GAN中的生成器网络。

- GN则在处理小批量数据时表现出色,特别适合资源受限的环境。

选择合适的归一化方法对于提高模型的训练效率和性能至关重要。在实际应用中,研究者们往往会根据具体任务和数据特点,灵活选择或组合使用这些归一化技术,以达到最佳的训练效果。